히스토그램 정보와 dark channel prior를 이용한 다해상도 기반 단일 영상 안개 제거 알고리즘

Copyright © The Korean Society of Marine Engineering

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0), which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 논문에서는 효과적인 단일 영상 안개 제거 알고리즘을 제안한다. 잘 알려진 안개 제거 알고리즘인 dark channel prior(DCP)는 경계선 영역에서의 후광 현상(halo artifact) 및 결과 영상의 저대비를 초래하고 전달량 정제(refinement) 과정에서 긴 계산 시간을 필요로 한다. 이러한 문제들을 해결하기 위해 제안한 방법은 전달량을 추정할 때 DCP와 히스토그램 정보로 구성된 비용함수를 이용하고, 빠른 처리를 위해 다해상도 기법을 이용한다. 히스토그램 정보는 안개 제거 결과의 저대비 현상을 방지해주고, 에지 정보를 참고하는 다해상도 기법은 계산 시간을 감소시키고 후광 현상을 방지할 수 있다. 다수의 안개 영상에 대한 실험을 통해 제안한 방법이 기존의 방법들보다 효율적이고 우수함을 확인하였다.

Abstract

In this paper, we propose a defogging algorithm for a single image. Dark channel prior (DCP), which is a well-known defogging algorithm, can cause halo artifacts on boundary regions, low-contrast defogging images, and requires a large computational time. To solve these problems, we use histogram information with DCP on transmission estimation regions and a multi-resolution method. Local histogram information can reduce the low-contrast problem on a defogging image, and the multi-resolution method with edge information can reduce the total computational time and halo artifacts. We validate the proposed method by performing experiments on fog images, and we confirm that the proposed algorithm is more efficient and superior than conventional algorithms.

Keywords:

Defogging, Dark channel prior, Local histogram information, Edge information, Multi-resolution method, dark channel prior(DCP)키워드:

안개 제거, 지역 히스토그램 정보, 에지 정보, 다해상도 기법1. 서 론

최근 선박 및 플랜트 감시와 해양 생태 조사를 효율적으로 수행할 수 있는 지능형 무인 시스템에 대한 관심이 높아짐에 따라 관련 시설의 운영 및 제어를 위한 컴퓨터 시각(computer vision) 분야에 대한 연구가 진행되고 있다[1]. 컴퓨터 시각은 카메라로 획득한 시각정보를 분석하여 특정 물체 인식 및 장면을 이해하는 기술이다. 이러한 기술은 선박이나 플랜트 등에 적용되어 인간의 시각 기능을 구현하는 것이 가능하지만 해변이나 해상에서 운용되기 때문에 카메라로 획득한 영상이 안개(fog)와 같은 탁한 매질(tubid medium)에 영향을 받기 쉽다. 안개로 인해 영상의 물체들은 본연의 색 대신 무채색으로 표현되고 이는 영상의 모호함이 증가시켜 컴퓨터 시각 기술의 성능이 저하된다[2-6].

안개는 대기 중 수증기가 뭉쳐서 형성된 입자들에 의해 발생된다. 이 입자들은 빛을 더 산란시키는 특성을 갖기 때문에 장면의 대비(contrast)를 축소시키고 채도(saturation)를 감소시킨다. 따라서 이러한 영상에 대한 컴퓨터 시각 기능의 성능을 높이기 위해 안개와 같은 외부 요인들을 제거하는 과정이 필요하다.

안개 제거(defogging)는 대비 향상(contrast enhancement)[2][3]과 안개 모델링(haze modeling)을 이용한 기법[4]-[11]으로 나뉘어진다. MSR(Multi-Scale Retinex)과 CLAHE(Contrast-Limited Adaptive Histogram Equalization)으로 대표되는 대비 향상 기법은 복잡한 모델링 과정 없이 영상을 여러 영역으로 나눈 후 각 영역의 대비 분포에 맞게 대비 확장 처리를 한다[3]. 이러한 방법들은 비교적 간단한 방법으로 대비가 낮은 안개 영상의 명확성(fidelity)을 증가시킬 수 있다는 장점이 있으나 지역적인 대비 분포 정보에 의존하기 때문에 결과 영상이 전체적으로 부조화를 이루기 쉽고 색상의 왜곡이 발생하기 쉽다[4].

안개 모델링을 이용한 기법은 영상을 광학적으로 모델링하여 안개와 관련된 파라미터를 계산하여 영상을 복원한다. 이 방법은 장면의 깊이(depth)와 관련있는 전달량(transmission)을 추정하는 과정을 거친다. Schechner et al. [5][6], Narasimhan et al. [5][7]-[8], Kopf et al. [9]는 여러 장의 영상을 이용하거나 GPS 정보 등의 추가 정보를 이용하는 방법을 제안하였다. 최근 안개가 포함된 영상 한장에서 안개를 제거하는 단일 영상 기법에 대한 연구가 활발히 이뤄지고 있다. Tan et al. [2]은 인접한 화소들의 깊이값이 비슷하다는 가정과 안개 영역에서는 밝기 차이의 합이 아닌 안개 없는 영역보다 적다는 가정을 이용하여 지역적으로 안개 영역을 찾아내는 방법을 제안하였고 Fattal et al. [11]은 안개 영상에서 반사율을 추정하여 안개를 제거하는 방법을 제안하였다. He et al. [4][12]는 dark channel prior(DCP)를 이용한 방법을 제안하였다. 이 방법은 안개가 없는 영역의 r, g, b 값 중 최소값(dark channel)이 안개 영역에 비해 매우 작은 값을 갖는다는 점을 이용하여 안개값(airlight)과 전달량을 계산하는 방식으로, 다양한 형태의 안개 영상에서 좋은 성능을 보인다고 알려져있다. 그러나 결과 영상의 대비가 작고, 영상의 경계선 영역에서 제거되지 않은 안개로 인해 후광 현상(halo artifact)이 발생하기 쉬우며, 블록 형태로 추정된 전달량을 정제(refinement)하기 위해 많은 계산량을 요구하는 단점이 있다. Yang et al. [13]은 DCP 처리 이후 전달량 정련 과정 대신 DCP 처리 영상에 히스토그램 명세화(histogram specification)을 적용한 방법을 제안하였다. 이 방법은 비교적 적은 계산량으로도 후광 현상을 감소시키고 안개 제거 영상의 명확성을 향상시키는 장점이 있으나 히스토그램 처리시 흑백 영역에서 처리하기 때문에 채도 영역에서 왜곡이 발생하기 쉽다.

따라서 본 논문에서는 안개 영상에서 전달량을 효율적으로 추정하여 안개를 제거하는 방법을 제안한다. 제안한 방법은 DCP 기반으로 안개 영역을 추정하는 과정에서 히스토그램 정보를 추가하여 저대비 및 색 왜곡을 방지하였다.. 다해상도 기법은 가우시안 영상 피라미드를 이용하였고 다해상도 처리 과정에서 에지 정보를 이용하여 영상의 에지부근에서의 후광 현상을 줄이는 동시에 전달량 정제 과정중 계산량을 줄일 수 있었다.

2. dark channel prior 기반의 안개 제거 방법

2.1 안개 모델

안개 제거는 안개가 포함된 원영상에서 안개 영역을 검출하고 안개의 정도를 추정한 후 안개 영역에서 안개를 배제한 영상을 얻는 과정을 말한다. 안개를 포함한 영상 I (x)는 안개 모델을 이용하여 식 (1)과 같이 나타낼 수 있다[1].

| (1) |

J (x) 은 안개가 제거된 영상이고, t(x) 는 물체의 색이 산란되지 않고 카메라에 획득된 정도를 나타내는 전달량이다. A 는 안개값(fog value)이며 안개가 전체 화소에 영향을 준 정도를 나타낸다. 여기서 전달량 t(x) 는 식 (2)와 같이 화소의 깊이에 대한 지수감소함수 형태로 표현된다.

| (2) |

여기서 β는 산란 계수(scattering coefficient)이고 d(x) 는 화소위치 x의 깊이를 나타낸다. 먼 물체일수록 깊이가 크기 때문에 안개에 의해 산란되는 정도도 커서 카메라까지 전달되는 정보가 감소함을 의미한다. 그리고 안개값 A 가 크게 반영되기 때문에 안개의 색이 더 강하게 나타나게 된다. 따라서 안개 제거 알고리즘은 안개 모델링 식 (1)에서 획득한 영상 I (x)에서 전역적 안개값 A 와 각 화소의 전달량 t(x) 를 추정하여 J (x)를 계산하는 과정을 말한다. r, g, b 중 채널 c에 대한 안개 제거 영상은 식 (3)과 같다[4].

| (3) |

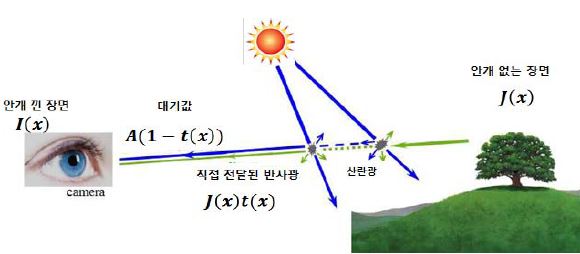

안개 모델링의 원리는 Figure 1과 같다. 우측의 소나무를 담은 원래 장면 J는 안개가 끼었을 경우 안개를 구성하는 대기 중 성분에 의해 산란되는 등의 이유로 온전히 전달되지 못하고 안개가 포함된 채로 카메라나 사람의 눈에 도달하게 된다. 이는 대기 중에 산란된 빛의 양 A{1 - t(x)}와 물체로부터 되어 도달하는 빛의 양 J (x)t(x)이다.

2.2 Dark Channel Prior

DCP는 안개 영상의 각 화소들의 r, g, b 각 채널값을 분석해보면 안개가 없는 영역의 화소는 적어도 한 채널의 값이 0에 수렴한다는 통계적 특성을 이용한다[4].

임의의 안개 영역 Ω(x)에서 안개를 걷어낸 화소 x의 dark channel Jdark (x)는 식 (4)과 같다.

| (4) |

여기서 y는 중심화소 x의 주변영역 Ω(x)에 포함된 화소이고 Jc (y)는 안개를 걷어낸 화소 y의 각 채널값이다. 안개가 없는 영역의 dark channel, 즉 Jdark (x)는 0에 수렴한다. 획득된 안개 영상 I (x)에서, 임의의 안개 영역 Ω(x)의 안개값 A 은 0이 아니므로 식(1)에 식(4)을 대입하여 식 (5)를 얻을 수 있다[4].

| (5) |

일반적으로 안개 영상에서 안개의 영향이 적은 지역은 고대비(high contrast) 특성을 가지기 때문에 r, g, b 각 채널간의 최대값과 최소값의 차이가 대체로 크다. 반면 안개가 많은 지역은 빛의 산란에 의해 대체적으로 화소값이 높고, 저대비(low contrast) 특성을 지니기 때문에 dark channel이 상대적으로 높다[3][4]. 이러한 특성을 안개 영상의 dark channel과 안개값을 구하는데 사용한다. 이 때 사전에 지정된 크기의 M ×M 크기의 윈도우를 이용하며, 윈도우 내에 있는 화소들의 r, g, b 성분들 중 최소값을 윈도우가 있는 영역의 dark channel로 정한다.

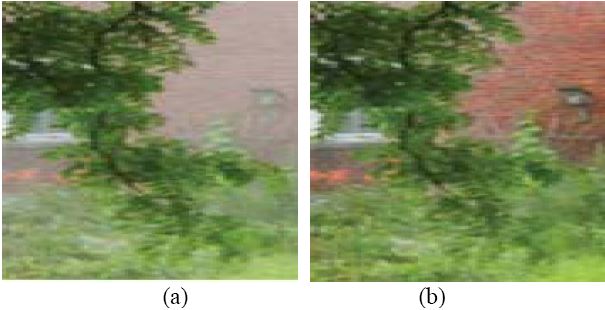

DCP를 이용하여 안개 제거한 결과는 Figure 2와 같다. 동일한 안개 모델하에서 색왜곡이 적고 자연스럽게 안개가 제거되었으나 결과 영상의 대비가 적어서 덜 선명해 보이고, 특히 가까운 나무의 경계 부근의 안개가 불완전히 제거되어 후광 현상이 발생한 것을 볼 수 있다.

3. 제안한 안개 제거 방법

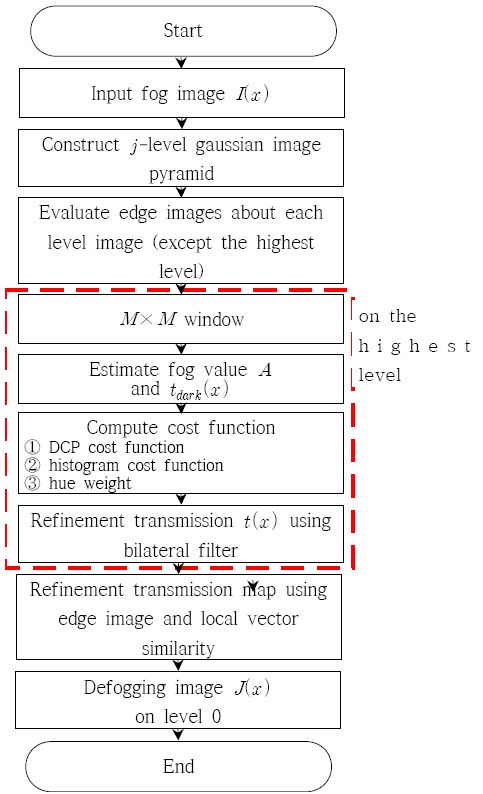

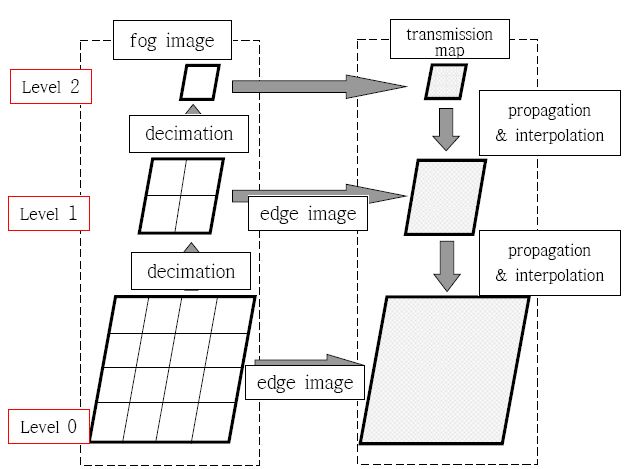

제안한 방법의 순서도는 Figure 3과 같다. 안개 영상 I (x) 를 획득한 후 j단계 계층의 가우시안 영상 피라미드를 구축한다. 영상 피라미드에서 j - 1단계 최상위 레벨의 영상은 원영상인 0 레벨에서 2j - 1배 축소된 영상이다. 이 때 최상위 단계 영상을 제외한 나머지 계층 영상의 에지 영상을 추출한다. 이는 이후 원영상 크기로 복원하는 과정에서 전달량 맵을 효율적으로 정제하는데 사용된다.

영상 피라미드를 구축한 후, 최상위 계층 영상에 대해 안개 제거를 수행한다. 먼저 M ×M 크기의 윈도우 영역에서 DCP를 이용하여 안개값 A 와 전달량 tdark (x) 를 추정한다. 그리고 DCP 비용항, 히스토그램 균등화 항 및 색상 가중치를 포함한 비용 함수를 계산하여 전달량 t(x) 를 구한다. 최상위 계층 전달량 맵은 bilateral filter[1][12]를 이용하여 정제 처리를 한다. 마지막으로 상위 계층에서 얻은 전달량 맵을 하위 계층으로 전파함과 동시에 에지 영상을 이용하여 복원하면서 에지 화소 주변을 bilateral filter로 정제한다.

3.1 DCP를 이용한 안개값 및 전달량 추정

주어진 윈도우 영역의 안개값 추정을 위해 윈도우 내의 화소들을 분석하여 r, g, b 중 가장 어두운 채널을 각 화소의 dark channel로 선택한다. 그리고 dark channel들의 상위 0.1%의 값들을 배제한 후, 남은 dark channel들 중 가장 밝은 채널값을 그 영역의 안개값 A 로 지정한다. 상위 0.1%의 제한을 두는 이유는 윈도우 내에 안개 아닌 흰색 물체가 있을 때 그 색이 안개값으로 선정되는 것을 방지하기 위함이다[4].

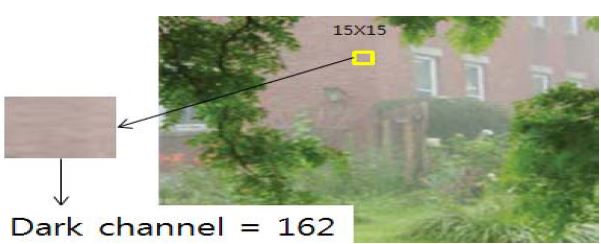

실제 안개 영상에서 안개값을 추정하는 예는 Figure 4와 같다. 중앙상단에 위치한 15 × 15 크기의 빨간색 윈도우 영역의 r, g, b 값들을 분석하여 dark channel 중 상위 0.1%인 162라는 값을 찾았다. 이는 해당 영역의 안개값이다.

이 후 안개값과 입력영상을 식 (5)에 대입하여 전달량 tdark (x) 를 얻는다. 이는 DCP 비용항, 히스토그램 균등화항 및 색상 가중치 계산의 기준값으로 사용된다.

3.2 비용 함수

제안한 방법의 비용 함수는 DCP 항과 히스토그램 균등화 항의 가중합으로 표현되며, 적용하는 가중치는 해당 영역의 안개 제거 전의 색상(hue)값과 현재 전달량에 의해 얻어진 새로운 색상값의 비로 결정된다.

윈도우 영역의 DCP 비용항 SD (t) 는 식 (6)과 같다.

| (6) |

여기서 Jdark (x)는 M ×M 윈도우내의 화소 x에 대해 DCP를 이용해 얻은 전달량 tdark (x)에 의해 안개를 제거한 화소값이고 L 은 최대명암도로써 보통 256이다. Jc (t(x))는 특정 전달량 t(x) 에 대한 안개 제거 결과 얻은 화소값이다. 이는 현재 추정한 전달량에 의해 얻어진 안개 제거 결과와 순수 DCP로 얻어진 안개 제거 결과와의 절대차합(SAD)에 대한 평균을 [0,1] 사이의 값을 갖도록 정규화한 값이다.

히스토그램 균등화 항은 HSI 색공간에서 I차원의 값을 이용한다. 히스토그램 균등화 항 SHE (t) 는 식 (7)와 같다.

| (7) |

이 때 M2은 해당 윈도우 영역의 크기, 즉 윈도우 영역내에 있는 총 화소수이고 hi (t(x)) 는 현재 화소 x에서의 임의의 전달량 t(x) 에 대해 얻어진 화소의 화소값 i에 해당하는 히스토그램의 bin값이며 해당 윈도우 영역에서 히스토그램 성분들이 균등하게 분포될수록 작은 값을 갖는다.

제안한 방법의 비용함수의 주요 항은 앞서 설명한 DCP항과 히스토그램 균등화 항이다. 여기에 안개 제거 과정에서 색상이 왜곡되는 것을 방지하기 위해 먼저 전달량에 대한 색상 함수 F (t(x))는 식 (8)과 같이 계산한다.

| (8) |

이 때 M2은 해당 윈도우 영역의 크기, 색상 함수 H (Jdark )는 DCP로 얻은 안개 제거 영상의 특정 화소에 대한 색상값이고 H (J (t(x)) 는 특정 전달량 t(x)에 대한 안개 제거 영상의 특정 화소에 대한 색상값을 나타낸다. ghue는 HSI에서 hue가 360o주기로 반복되기 때문에 식 (9)와 같다[13].

| (9) |

색상 가중치 ωhue는 색상함수 F hue (t) 를 이용하여 식 (10)와 같이 지수함수로 나타낼 수 있다.

| (10) |

순수 DCP로 얻은 안개 제거 영상과 특정 전달량에 의한 색상차가 커질수록 F (t)가 커진다. 이 때 색상 가중치 ωhue의 값은 반대로 작아지므로 처리 과정에서 색상 왜곡이 발생했을 때 비용 함수에 반영해주는 용도로 사용할 수 있다. 한편 색상 왜곡은 DCP보다 대비 향상 방법에서 많이 발생하므로 색상차가 클 경우 두 비용항이 각각 독립적으로 서로 다른 전달량을 계산했다면 히스토그램 균등화 항의 비용을 높여줌으로써 DCP로 얻은 전달량이 우세하도록 하는 역할을 맡을 수 있다.

따라서 최종적으로 계산하는 총비용함수 S total (t(x))는 식 (11)과 같이 나타낼 수 있다.

| (11) |

이러한 과정을 통해 안개 영상의 모든 화소에 대한 전달량은 한 장의 전달량 영상 또는 전달량 맵으로 나타낼 수 있다.

3.3 다해상도 기법

상기 과정으로 얻은 전달량 맵은 보다 정확한 안개 제거를 위해 정제(refinement)과정을 거친다. 정제과정에서 bilateral filter를 이용하는 soft-matting 기법이 가장 많이 쓰이며, 조밀한 전달량 맵을 얻기 위해서는 그만큼 처리 시간이 많이 소요되는 단점이 있다[12]. 따라서 제안하는 방법은 정제과정에서 계산량을 줄이기 위해 가우시안 영상 피라미드를 이용한다. 가우시안 영상 피라미드는 상위 레벨로 축소된 영상을 더 자세히 표현해주는 장점을 가지고 있다[1].

안개 영상에 대한 다해상도 영상 피라미드를 j단계로 구현하면 j단계의 근사영상과 예측차 영상 피라미드가 각각 생성된다. 근사영상은 가우시안 피라미드를 이용하여 2배식 축소된 영상이고, 예측차 영상은 저레벨로 복원시 필요한 차영상이다. 안개 영상에 대해 영상 피라미드를 구축할 경우 예측차 영상에도 안개 성분이 포함되기 때문에 제안한 방법은 예측차 영상을 사용하지 않고 각 단계 근사영상에서 추출한 에지 영상을 이용한다. 에지 영상은 canny 연산자를 이용하여 추출한다[1].

제안한 다해상도 기법은 Figure 5와 같다. 3단계로 구성된 안개 영상 피라미드의 최상위 계층에서 앞절의 과정으로 전달량 맵을 구하고 bilateral filter를 이용하여 전달량 맵을 정제한다. 화소수가 1/16배이므로 연산에 큰 시간이 소요되지 않는다. 최상위 전달량 맵은 하위 계층으로 확대하며 전파(propagation)한다. 전달량 맵의 에서 화소 (x,y)가 2배 확대되면 이 화소값은 2배 확대된 영상, 즉 레벨 j -1의 (2x,2y) , (2x + 1,2y) , (2x,2y + 1) , (2x + 1,2y + 1)위치에 그대로 전파한다. 이 때 전단계에서 추출한 에지 영상을 토대로 에지 화소 유무를 판별하여 에지 화소가 없는 화소의 전달량은 그대로 전파한다. 만약 에지 화소가 있다면 현재 단계 근사영상를 이용하여 해당 에지 화소 위치에서의 전달량을 다시 계산하고 정제과정을 거친다. 이는 에지 화소 유무에 따라 전달량 계산 및 정제과정을 거치므로 전체적인 전달량 정제과정에서 수행하는 연산량을 크게 감소시킬 수 있다.

4. 실험 및 고찰

제안한 방법의 성능을 검증하기 위해 안개 분포의 특성에 따른 결과 영상을 제시하고 기존의 DCP 방법[12]의 결과와 비교하였다. 다양한 안개 특성에 대한 성능을 확인하고 비교하기 위해 분포된 영역의 크기 및 농도가 다른 안개 영상들을 사용하였다. 성능 검증은 안개 제거 영상의 시각적 선명도의 정성적 비교 및 처리 전후 에지 화소 비율 산출을 통한 정량적 비교를 통해 수행하였고, 계산 시간을 산출하여 처리 속도를 비교하였다. 실험시 적용된 각종 파라미터 등 실험 조건들은 Table 1과 같다.

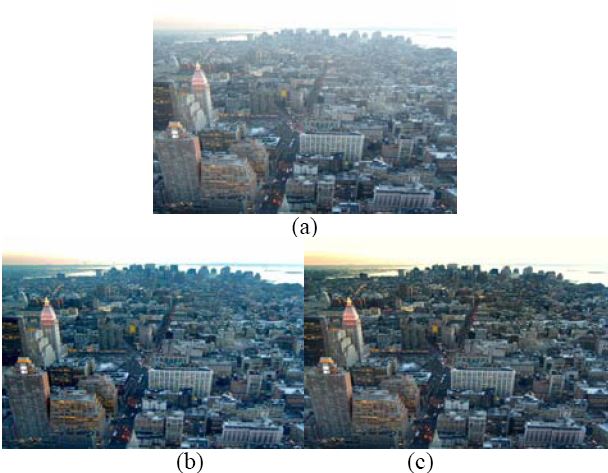

전역적 안개 영상과 안개 제거 영상은 Figure 6과 같다. 안개영상은 Figure 6의 (a)와 같이 원거리에서 촬영하였기 때문에 장면 전체적으로 안개가 관찰된다. 이 영상을 DCP와 제안한 방법으로 처리한 결과 영상은 각각 Figure 6의 (b)와 (c)이다. 제안한 방법을 통해 안개 제거 과정에서 경계선을 명확히 표현하고, 불켜진 건물창의 색등이 선명하게 표현될 수 있음을 확인할 수 있다.

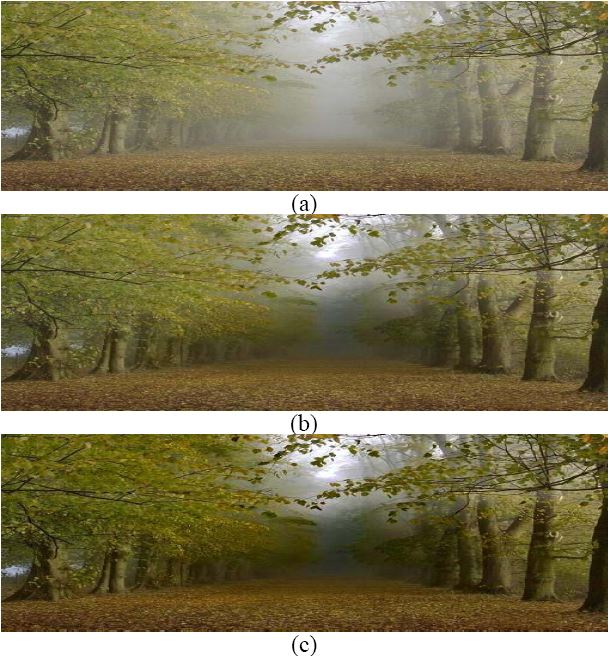

두 번째 실험영상은 Figure 7과 같이 근거리 사물을 제외한 배경영역에 안개가 보인다. DCP 처리 결과는 Figure 7의 (b)이다. 좌측에 보이는 나뭇가지와 잎 뒤쪽의 안개 영역과 겹치는 부분에서 안개가 제거되지 못하고 후광 현상이 발생하였고, 우측 상단에 걸쳐진 나뭇잎들의 경계가 뭉개져 있다. 이는 안개 영역의 전달량을 추정하는 과정에서사물의 경계선을 명확히 반영하지 못해 발생한다.

제안한 방법의 결과는 Figure 7의 (c)이다. DCP에서 발생한 후광 현상 문제가 개선되었고 우측 상단 물체의 디테일도 잘 보전되었음을 확인할 수 있다. 제안한 방법은 전달량을 정제하는 과정에서 원영상의 에지 정보를 이용하기 때문에 본 실험영상과 같이 안개 영역과 겹치는 부분에서 더 좋은 성능을 보인다.

세 번째 실험영상은 Figure 8이다. 깊이가 큰 영역을 중심으로 안개가 집중되어 있고 주변에는 옅게 분포되어 있다. 특히 영상의 중심부 영역은 깊이 정보가 크고 안개값이외에 물체의 색정보가 희박하기 때문에 전달량이 작다. 따라서 나무색이 희박하게나마 전달된 곳까지는 복원이 가능하지만 그 외의 영역은 기존의 방법과 제안한 방법 모두 성능의 한계를 드러냈다. 반면 복원된 영역의 디테일과 대비의 폭은 제안한 방법이 더 좋았다.

제안한 방법의 성능을 정량적으로 검증하기 위해 안개처리 전후 에지 화소 비율[15]을 계산하여 Table 2에 보였다. 이 수치가 높을수록 안개 제거 과정에서 에지의 선명도가 증가했다는 의미로 볼 수 있다.

마지막으로 제안한 다해상도 기반의 안개 제거 기법의 효율성을 보이기 위해 기존 bilateral filter를 이용하여 전달량 맵을 정제하는 DCP 방법과 제안한 방법의 연산 시간을 Table 3으로 보였다.

기존 DCP의 전달량 정제 과정에서는 원영상 크기의 전달량 맵과 안개 영상에 대해 bilateral filter를 적용하기 때문에 경계 영역을 보전하면서 전달량 맵을 정제하는데 오랜시간이 걸린다. 제안한 방법의 전달량 추정과정에서 DCP연산뿐만 아니라 히스토그램 비용항과 색상 가중치를 계산하는 만큼의 연산량이 증가됨에도 기존의 방법보다 짧은 시간내에 결과 영상을 도출했다.

5. 결 론

본 논문에서는 안개 영상에서 전달량을 효율적으로 추정하여 안개를 제거하기 위해 히스토그램 분포와 DCP를 이용한 다해상도 기반의 단일 영상 안개 제거 기법을 제안하였다. 제안한 방법은 안개 모델링을 이용하여 DCP와 히스토그램 분포 특성에 대한 비용항의 가중합 형태로 전달량에 관한 비용함수를 정의하였고, 안개 제거 처리 전후 색의 왜곡이 적은 DCP의 특성에 입각하여 DCP로 얻은 기준 전달량을 이용하여 색 왜곡 정도에 따른 가중치를 계산한 후 비용함수에 적용하였다. 그리고 에지 정보를 추가한 다해상도 기법을 이용하여 전달량 정제를 수행하였다. 제안한비용함수는 색 왜곡이 적다고 판단되는 영역에서는 히스토그램 처리의 비중을 높여서 장면의 명확성을 높일 수 있었고, 색 왜곡이 발생하는 영역에서는 DCP 처리의 비중을 높임으로써 색 왜곡을 방지할 수 있었다. 다해상도 기법은 조밀한 전달량 맵을 얻는 시간 단축에 효과가 있었고, 특히 추가된 에지 정보를 이용함으로써 후광 효과를 방지할 수 있음을 확인할 수 있었다. 반면 제안한 방법의 안개 제거처리 시간은 실시간 처리 기준에 못 미친다. 이를 위해 FPGA 등 H/W 처리 기법이나 GPGPU(general purpose GPU를 이용한 병렬 처리 기법 연구가 병행되어야 할 것이다.

References

- E. R. Davies, Machine Vision, Third Edition : Theory, Algorithms, Practicallities (Signal Processing and its Applications), Morgan Kaufmann, (2005).

- R. T. Tan, Morgan Kaufmann“Visibility in bad weather from a single image”, Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, p1-8, (2008).

-

J. H. Kim, J. Y. Sim, and C. S. Kim, “Single image dehazing based on contrast enhancement”, Proceedings of the IEEE Acoustics, Speech and Signal Processing, p1273-1276, (2011).

[https://doi.org/10.1109/icassp.2011.5946643]

-

K. He, J. Sun, and X. Tang, “Single image haze removal using dark channel prior”, IEEE Transactions on Pattern Analysis and Machine Intelligence, 33(12), p2341-2353, (2011).

[https://doi.org/10.1109/TPAMI.2010.168]

-

Y. Y. Schechner, S. G. Narasimhan, and S. K. Nayar, “Instant dehazing of images using polarization”, Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, p1984-1991, (2001).

[https://doi.org/10.1109/cvpr.2001.990493]

-

S. Shwartz, E. Namer, and Y. Y. Schechner, “Blind haze separation”, Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, p1984-1991, (2006).

[https://doi.org/10.1109/cvpr.2006.71]

-

S. G. Narasimhan, and S. K. Nayar, “Chromatic framework for vision in bad weather”, Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, p598-605, (2000).

[https://doi.org/10.1109/cvpr.2000.855874]

-

S. G. Narasimhan, and S. K. Nayar, “Contrast restoration of weather degraded image”, IEEE Transactions on Pattern Analysis and Machine Intelligence, 25(6), p713-724, (2003).

[https://doi.org/10.1109/TPAMI.2003.1201821]

-

J. Kopf, B. Neubert, B. Chen, M. Cohen, C. Cohen-Or, O. Deussen, M. Uyttendaele, and D. Lischinski, “Deep photo: Model-based photograph enhancement and viewing”, ACM Transactions on Graphics, 27(5), p1-10, (2008).

[https://doi.org/10.1145/1409060.1409069]

-

K. Gibson, D. Vo, and T. Nguyen, “An inversigation of dehazing effects on image and video coding”, IEEE Transactions on Image Processing, 21(2), p662-673, (2012).

[https://doi.org/10.1109/TIP.2011.2166968]

-

R. Fattal, “Single image dehazing”, ACM Transactions on Graphics, 27(3), p1-9, (2008).

[https://doi.org/10.1145/1360612.1360671]

-

K. He, J. Sun, and X. Tang, “Guided image filtering”, IEEE Transactions on Pattern Analysis and Machine Intelligence, 35(6), p1397-1409, (2012).

[https://doi.org/10.1109/TPAMI.2012.213]

- S. Yang, Q. Zhu, J. Wang, D. Wu, and Y. Xie, “An improved single image haze removal algorithm based on dark channel prior and histogram specification”, Proceedings of the 3rd International Conference on Multimedia Technology, p279-292, (2013).

- R. C. Gonzalez, and R. E. Woods, Digital Image Processing, Third Edition, Prentice Hall, (2007).

-

N. Hautiere, J. Tarel, D. Aubert, and E. Dumout, “Blind contrast enhancement assessment by gradient ratioing at visible edges”, Image Analysis & Stereology Journal, 27(2), p1-7, (2008).

[https://doi.org/10.5566/ias.v27.p87-95]