LMS algorithm을 이용한 배경분리 알고리즘 구현 및 성능 비교에 관한 연구

Copyright © The Korean Society of Marine Engineering

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0), which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

최근 정보화 및 컴퓨터 비전 기술의 발전과 함께 객체의 인식 및 추적 기능을 가진 CCTV시스템이 다양한 분야에서 연구되고 있다. 하지만 실외환경에서 발생할 수 있는 그림자의 변화, 조명의 변화, 움직이는 요소들과 같은 배경의 변화는 객체 인지성능에 영향을 주게 된다. 따라서 실외환경에서 배경의 변화를 실시간으로 갱신하기 위해 본 논문에서는 다양한 배경 모델링 기법들을 분석하고, 가중치를 기반으로 한 배경 갱신 알고리즘을 제안한다. 실험을 통해 제안한 알고리즘의 객체 검출 성능은 이전 연구의 객체 검출 성능을 유지하며, 오인식 된 객체 수가 이전 연구에 비해 감소됨을 확인하였다.

Abstract

Recently, with the rapid advancement in information and computer vision technology, a CCTV system using object recognition and tracking has been studied in a variety of fields. However, it is difficult to recognize a precise object outdoors due to varying pixel values by moving background elements such as shadows, lighting change, and moving elements of the scene. In order to adapt the background outdoors, this paper presents to analyze a variety of background models and proposed background update algorithms based on the weight factor. The experimental results show that the accuracy of object detection is maintained, and the number of misrecognized objects are reduced compared to previous study by using the proposed algorithm.

Keywords:

CCTV, Computer vision, Background update, Object detection, CCTV키워드:

컴퓨터 비전, 배경 갱신, 객체 검출1. 서 론

최근 폭발적인 CCTV 설치대수에 비해 모니터링 요원의 숫자는 실질적으로 부족하여 CCTV영상을 감시하는 데 물리적 한계가 발생하게 되며, 이러한 문제점을 해결하기 위하여 지능적이고 자율적인 상황인지 방식의 지능형 CCTV에 관한 연구가 활발히 진행 중이다. 뿐만 아니라 로봇의 자율주행 및 특정 랜드마크를 이용한 실내·외 위치인식 기술 등 동영상 또는 실시간으로 수집되는 영상에서 객체를 인지 및 추적하기 위한 컴퓨터 비전 기술은 컴퓨터 처리속도의 고속화와 다양한 영상 처리 기술의 개발에 의해 지속적인 발전을 이룩하고 있다[1]-[3].

하지만 인간의 시각과 동일한 성능을 가지는 컴퓨터 비전 시스템을 구성하는 데에는 여러 가지 제약이 있다. 특히 카메라가 고정된 상태에서 객체와 배경을 분리하는 경우, 실내 및 실외환경에서 다양하게 발생할 수 있는 외란 및 잡음에 의해 영상정보의 변화는 객체의 인지성능에 영향을 받게 된다. 따라서 이러한 배경의 변화에 적응하기 위한 전처리 · 배경모델링 · 후처리를 이용한 많은 연구가 진행되어 왔으며, 크게 통계적[4]-[7] · 비통계적[8]-[10], 픽셀기반[4]-[9] · 영역기반[10]-[13], 재귀적[4]-[6][8] · 비재귀적[7][9][10] 알고리즘으로 분류할 수 있으며, 실외환경에서 발생할 수 있는 다양한 오인식으로 인한 잡음을 줄이고 실시간 처리에 필요한 연산량 감소를 위한 다양한 연구가 진행 중이다[14][15].

본 논문에서는 배경영상 기반 영상 객체 인식 시스템에서 배경영상과 획득된 영상의 조명 변화가 발생한 경우, 이전의 방법과 비교하여 객체 검출의 성능은 유지하는 동시에 원활한 조명변화에 적응하기 위한 알고리즘을 제안한다. 제안한 방법은 획득된 영상과 배경영상의 픽셀 값에 LMS algorithm을 통해 산출된 가중치를 적용하여 배경변화에 실시간으로 적응하는 방법으로, 구현의 단순함으로 연산량 감소 및 객체 검출 성능 유지에 적합한 객체 검출 기법이다.

2. 관련이론

2.1 BCFD(Background and Current Frame Difference)

BCFD란 배경영상과 카메라로부터 획득되는 영상과 대응하는 화소를 비교하여, 정적인 영역(static region)과 움직이는 물체가 있는 영역(dynamic region)을 구분하여 영상에서 움직이는 물체가 있는 부분을 찾는 방식이다.

| (1) |

Equation (1)에서 It, (x,y)는 시간 t에서 획득되는 영상의x,y좌표에 위치하는 픽셀의 명도 값을 의미하며, B(x,y)는 사전에 획득한 배경영상의 x,y 좌표에 위치하는 픽셀의 명도 값을 의미한다. Ot, (x,y)는 It, (x,y)와 B(x,y) 간의 차이의 절대값이 임계값보다 큰 경우 1을 취하고, 그렇지 않은 경우 0으로 설정한 이진 신호이며, 공간영역의 x 및 y좌표상에 배열되어 물체가 있는 영역을 인식하게 된다.

2.2 LMS algorithm

신호의 변화 혹은 혼입된 잡음의 제거는 고정형태나 적응형태의 필터를 이용하여 신호를 개선할 수 있는데, 일반적으로 고정된 필터의 경우 사전에 신호와 잡음의 특성에 대한 정보를 알고 있어야 하는 반면, 적응형 필터는 그 자신이 자동적으로 필터인자 각각을 조절할 수 있다. 특히, 적응형 필터는 입력신호가 시간에 따라 변화하거나, 잡음 혹은 신호 변화의 특성을 알 수 없을 경우 유용한데, 이때 LMS(Least Mean Square) 알고리즘이 필터인자를 찾는데 식의 간편함으로 널리 사용되고 있다.

| (2) |

| (3) |

| (4) |

| (5) |

Equation (2)에서 xn은 입력신호의 벡터를 의미하며, Equation (3)의 An은 가중치의 벡터를 의미한다. Equation (4)에서 yn은 필터의 출력을 의미하며, Equation (5)에서 En은 필터출력 yn과 요구되는 신호 dn와의 차가 된다.

| (6) |

LMS 알고리즘은 Equation (6)에 따라 새로운 데이터가 도달할 때 마다 가중치 벡터 An을 새롭게 갱신함으로써 자승의 평균 오차를 최소로 한다. 이때 μ는 수렴에 이용되는 학습률이며, μ값이 크면 수렴속도는 빠르나 그 오차가 입력 신호에 따라 커지는 경우가 생기며, μ값이 작으면 수렴속도는 늦는 반면 오차는 최종적으로 적게 된다.

3. 제안한 객체 인식 알고리즘

3.1 적응형 배경 기반 객체 인식 기법

기존의 BCFD 기법의 경우, 빛 변화 및 기후적 잡음으로 인한 실외환경에 실제 획득된 영상과 배경의 변화가 발생하였을 경우, 객체 영역 뿐만 아니라 정적 영역의 경우에도 객체영역으로 인식하는 문제점이 있다.

따라서 본 논문에서는 실외환경에서 카메라로부터 획득된 영상과 배경이 빛 변화 및 기후적 잡음으로 인해 변화가 발생하였을 경우, 배경의 변화를 인식하고, 배경을 자동으로 갱신할 수 있는 기법을 통하여 실제 획득된 영상에서 객체영역을 비교적 정확하게 인식할 수 있는 기법을 제안한다.

| (7) |

| (8) |

| (9) |

먼저 시간 t에 카메라로 획득된 영상을 Equation (7)과 같이 표현한다면, 이와 동일하게 배경영상을 Equation (8) 과 같은 2차원의 배열로써 표현이 가능하다. 그리고 본 논문에서는 획득된 영상의 각 픽셀에 가중치를 적용하기 위해서 동일한 크기의 가중치 배열을 생성하였으며, Equation (9)와 같이 표현이 가능하다.

| (10) |

| (11) |

객체의 영역을 알 수 있는 출력 영상의 각 픽셀 값을 구하는 방법은 Equation (10)과 같으며, 각 픽셀의 배열은 Equation (11)과 같이 나타낼 수 있다. 이때, T는 임계값을 의미한다.

| (12) |

| (13) |

한편, LMS 알고리즘을 구현하기 위해서 배경영상에서 획득된 영상과 가중치를 곱하여 뺄셈연산을 해주며, Equation (12)에서 알 수 있듯이, 이 연산은 각 픽셀마다 적용된다.

시간 t+1에 사용할 가중치를 산출하는 방법은 Equation (13)과 같으며, n번째 동일한 입력신호에 대해 가중치를 반복적으로 산출한 후, 오차가 수렴하거나, n번 반복이 완료되면 Wt+1, (x,y)을 산출한다.

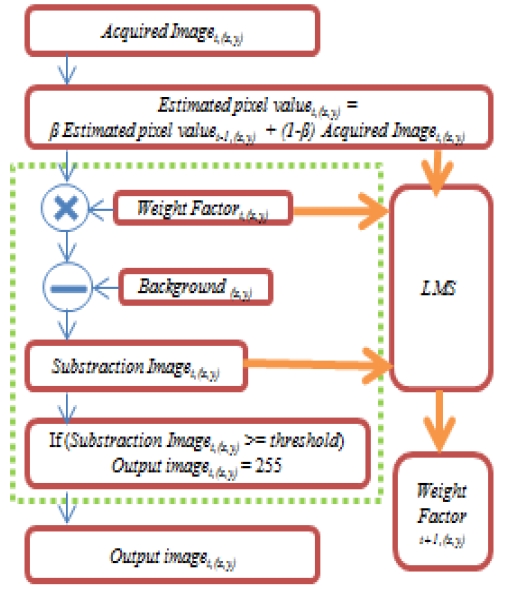

Figure 1은 제안한 방법의 블록 다이어그램을 나타낸 것이다.

4. 실험 및 고찰

4.1 실험 환경

실험은 한국해양대학교 공과대학 1호관과 후생복지관 사이의 도로 및 주차장이며, 2014년 5월 31일 4시 30분에 배경영상을 촬영하고, 동일한 시간부터 5시 30분까지 배경과 획득된 영상의 차이가 급격히 달라지는 일출기간 동안 동영상으로 촬영하였다. 배경영상 및 획득된 영상은 320×240의 컬러영상을 기준으로 실험을 진행하였으며, 이때 동영상으로부터 획득된 영상은 1차 저주파 필터를 이용하여 고주파 성분을 제거하여 실험을 진행하였다. 개발언어 C++ 및 OPENCV를 이용하여 알고리즘을 구현하고 실험결과를 획득하였다.

4.2 배경 변화 요소

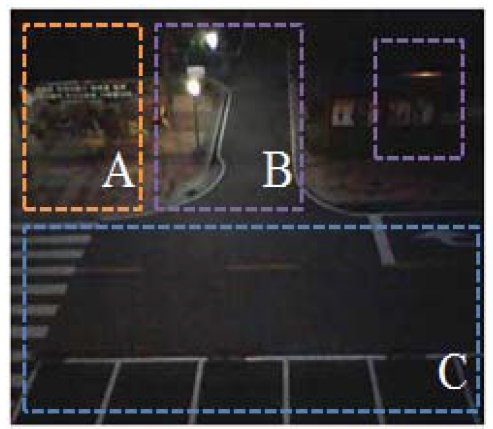

본 논문에서 사용된 영상에서 배경의 변화에 의해서 객체의 오인식 혹은 미인식 상황이 발생하는 경우를 Figure 2에서 나타내었다. Figure 2-A는 실외환경에서 빈번히 발생하는 대류의 순환에 의해 나뭇가지, 깃발, 와이어등이 움직이면서 발생하게 되는 배경의 변화구역을 표시하였다. Figure 2-B는 사용자가 임의로 구성한 조명의 작동상태에 따라 광원 및 광원이 비추는 주위의 전반적인 영역에 화소값의 변화가 생기게 되며 배경의 변화가 발생한다. Figure 2-C는 움직이거나 변화가 없는 구간이지만, 일출 혹은 일몰에 따른 조명의 변화로 인하여 화소값의 변화로 나타나게 되며, 특히 화소값이 높은 배경화소의 경우 그 오차는 더욱 커지게 되는데, 이는 화소값이 높은 배경이 더욱 조명의 변화에 민감함을 실험을 통해 확인할 수 있다.

4.3 실험 결과

본 논문에서는 총 3가지의 실험결과를 통해 제안한 방법의 유효성을 검토하였다. 첫 번째는 시간에 지남에 따른 적응 여부를 평가하였으며, 두 번째는 조명의 변화에 성능여부를 검토하였으며, 세 번째는 최종적인 적응형 배경 모델을 통한 객체 인식 여부를 확인하였다.

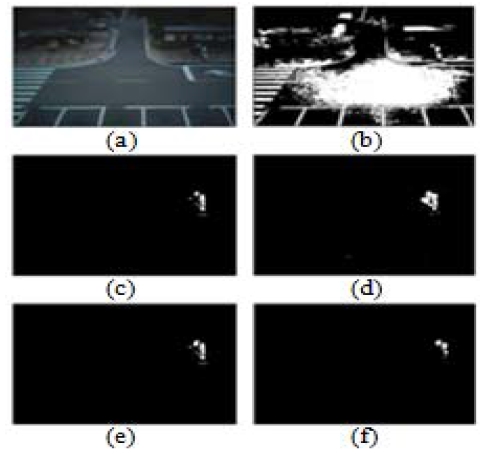

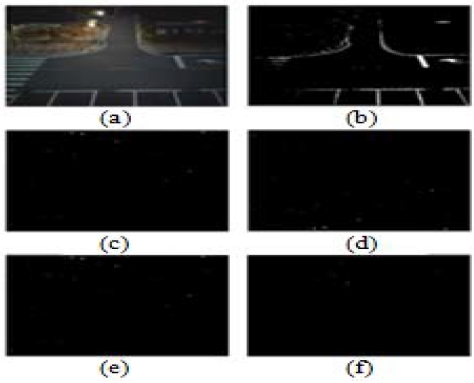

Figure 3은 4시 30분의 배경영상과 4:40분에 획득된 영상을 비교한 실험이다. LMS를 이용하지 않은 경우, 실제 화소값이 높은 영역으로부터 오차가 심하게 발생함을 알 수 있다. 하지만 이전의 연구와 제안한 방법의 경우 배경영상과 획득된 영상의 차이가 거의 없음을 알 수 있다. 획득된 영상 속에 객체가 존재하지 않을 경우에도 시간이 지남에 따라 객체로 인식되는 오인식 영역이 실험 결과영상의 공간영역에 부분적으로 발생하게 되며, 이상적인 결과영상과 실제 결과영상의 잡음발생 비율을 Table 1에 나타내었다. PSNR은 각각 28.98, 28.36, 28.64, 29.07로 나타났으며, 각각 알고리즘의 평균 처리속도는 각각 57fps, 56fps, 123fps, 60fps이다.

Experimental results of (a) Acquired image (after 10 minutes) , (b) Subtraction image, (c) RGA, (d) GMM, (e) AMF and (f) Proposed method

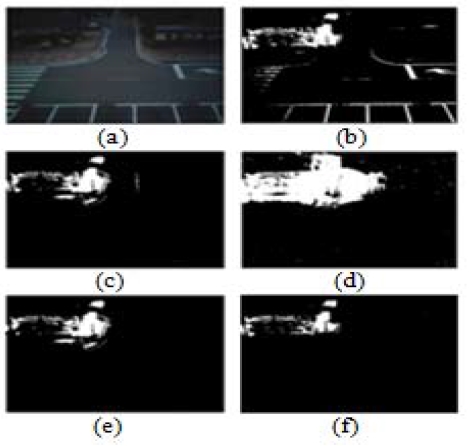

Figure 4는 4시 30분의 배경영상과 5시에서 5시 15분 사이에 획득된 영상을 비교한 실험이다. Figure 3과 다른 점은 가로등에 의한 오차 발생 여부이다. LMS을 이용하지 않은 경우, 가로등이 비추고 있는 영역에 오차가 상당수 발생함을 알 수 있다. 이전의 방법과 제안한 방법 역시 오차가 발생하지만, 수초 이내로 변화를 갱신하여 동일한 영역에서 오차가 줄어들어 적응되는 성능을 확인할 수 있다.

Experimental results of (a) Acquired image (street lamp off) , (b) Subtraction image, (c) RGA, (d) GMM, (e) AMF and (f) Proposed method

Figure 5는 실제 객체가 존재할 경우, 객체 인식 여부에 관한 실험이다. LMS을 적용하지 않은 경우에도 객체를 인식할 수 있지만, 배경에 의한 오차에 의해서 실제 객체와 배경을 구분하기 힘들다. 하지만 제안한 방법은 배경의 변화에 비교적 적응적인 성능을 가지며, 실제 객체 검출이 기능함을 확인할 수 있다.

5. 결 론

본 논문에서는 배경영상 기반 영상 객체 인식 시스템에서 획득된 영상과 배경과의 조명 변화가 발생한 경우, 획득된 영상의 픽셀 값에 가중치를 적용하여 오류를 방지하며, 객체영역을 추출하는 기법을 제안하였다. 실외환경에서 일출 및 일몰 또는 가로등에 의한 조명 변화로 인해 획득된 영상과 배경의 차이가 발생하는 경우 제안한 시스템을 통한 획득된 영상 각 픽셀 값에 가중치를 적용하여 조명변화에 강인한 성능을 가지도록 하였다. 실험한 결과, 일출기간 및 가로등의 조명이 제거되었을 경우 유효성을 검토하였다. 향후, 적응적인 임계값을 통한 상황에 적합한 민감성을 판별하여 야간 및 조명상황이 악화된 경우 객체 검출에 관한 연구가 필요하다고 판단된다.

Acknowledgments

이 논문은 ISMT 2014(2014.09.17., pp. 76-78)에 발표된 논문을 보완 및 확장하여 새롭게 구성한 내용을 포함하고 있으며 2014년도 정부(교육부)의 재원으로 한국연구재단의 지원을 받아 수행된 기초연구사업임. (No. 2014R1A1A4A01008081)

References

- J. B. Jeon., “Intelligent CCTV Surveillance industry trends”, Telecommunications Technology Association, 142, p50-55, (2012), (in Korean).

- S. Stephen, D. Lowe, and J. Little, “Vision-based mobile robot localization and mapping using scale-invariant features”, Proceedings of the IEEE International Conference on Robotics and Automation, 2, p2051-2058, (2001).

-

X. Chen, and Y. Jia, “Indoor localization for mobile robots using lampshade corners as landmarks : Visual system calibration, feature extraction and experiments”, International Journal of Control, Automation and Systems, 12(6), p1313-1322, (2014).

[https://doi.org/10.1007/s12555-013-0076-y]

-

C. R. Wren, A. Azarbayejani, T. Darrell, and A. P. Pentland, “Pfinder : real-time tracking of the human body”, IEEE Transactions on Pattern Analysis and Machine Intelligence, 19(7), p780-785, (1997).

[https://doi.org/10.1109/34.598236]

-

C. Stauffer, and W. Grimson, “Adaptive background mixture models for real-time tracking”, IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2, p246-252, (1999).

[https://doi.org/10.1109/CVPR.1999.784637]

-

Z. Zivkovic, and F. Heijden, “Efficient adaptive density estimation per image pixel for the task of background subtraction”, Pattern Recognition Letters, 27(7), p773-780, (2006).

[https://doi.org/10.1016/j.patrec.2005.11.005]

-

E. Herrero-Jaraba, C. Orrite-Urunuela, and J. Senar, “Detected motion classification with a double-background and a neighborhood-based difference”, Pattern recognition Letters, 24(12), p2079-2092, (2003).

[https://doi.org/10.1016/S0167-8655(03)00045-X]

-

N. J. B. McFarlane, and C. P. Schofield, “Segmentation and tracking of piglets in images”, Machine Vision and Applications, 8(3), p187-193, (1995).

[https://doi.org/10.1007/BF01215814]

-

R. Cucchiara, C. Grana, M. Piccardi, and A. Prati, “Detecting moving objects, ghosts, and shadows in video streams”, IEEE Transactions on Pattern Analysis and Machine Intelligence, 25(10), p1337-1342, (2003).

[https://doi.org/10.1109/TPAMI.2003.1233909]

-

N. M. Oliver, B Rosario, and A. Pentland, “A bayesian computer vision system for modeling human interactions”, IEEE Transactions on Pattern Analysis and Machine Intelligence, 22(8), p831-843, (2000).

[https://doi.org/10.1109/34.868684]

- M. Seki, T. Wada, H. Fujiwara, and K. Sumi, “Background detection based on the cooccurrence of image variations”, IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2, p65-72, (2003).

- P. Noriega, B. Bascle, and O. Bernier, “Local kernel color histograms for background subtraction”, International Conference on Computer Vision Theory and Applications, 1, p213-219, (2006).

-

M. Mason, and Z. Duric, “Using histograms to detect and track objects in color video”, 30th IEEE workshop on Applied Imagery Pattern Recognition, p154-159, (2001).

[https://doi.org/10.1109/AIPR.2001.991219]

- J. D. Park, and D. S. Kang, “Implementation of an effective context-awareness system using object detection and classification algorithm”, Journal of the Korean Institute of Information Technology, 10(2), p191-197, (2012), (in Korean).

- D. H. Jang, A study on Fast Background Subtraction using integral Histogram, Ph,K. Department of Image Engineering, Chung-Ang University, Korea, (2008), (in Korean).